DistributePartager par :

- Copier le lien

- X

- Courriel

Partager cet article 0Joignez-vous à la conversationSuivez-nousAjoutez-nous comme source préférée sur GoogleBulletinAbonnez-vous à notre bulletin d’informationUn robot apprend à synchroniser ses lèvres – YouTube

Regarder sur

Êtes-vous sûr que la personne qui vous parle n’est pas un robot à 100 % ? Bientôt, vous pourriez ne plus en être aussi certain.

Pour la toute première fois, des scientifiques ont mis au point un robot capable de bouger la bouche exactement comme un humain. Cela signifie qu’il évite ce qu’on appelle l’effet de la « vallée dérangeante », où les actions d’un robot apparaissent troublantes parce qu’elles sont inconfortablement proches du naturel, mais n’atteignent pas tout à fait ce seuil.

Les chercheurs de l’Université Columbia ont réalisé cet exploit en permettant à leur robot, EMO, de s’étudier dans un miroir. Il a appris comment son visage flexible et ses lèvres en silicone bougeraient en réponse aux actions précises de ses 26 moteurs faciaux, chacun étant capable de bouger jusqu’à 10 degrés de liberté.

Vous aimerez peut-être

-

Regardez : le nouveau robot humanoïde d’une entreprise chinoise bouge si doucement qu’ils ont dû l’ouvrir pour prouver qu’une personne ne s’y cachait pas

-

Pourquoi l’essor des robots humanoïdes pourrait rendre les interactions moins agréables

-

L’IA peut développer une « personnalité » spontanément avec un minimum d’invites, selon une étude. Qu’est-ce que cela signifie pour la façon dont nous l’utilisons ?

Ils ont décrit leurs méthodes dans une étude publiée le 14 janvier dans la revue Science Robotics.

Comment EMO a appris à bouger son visage comme un humain

EMO utilise un système d’intelligence artificielle (IA) appelé modèle de langage « vision-action » (VLA), ce qui signifie qu’il peut apprendre à traduire ce qu’il voit en mouvements physiques coordonnés sans règles prédéfinies. Pendant l’apprentissage, le robot humanoïde a fait des milliers d’expressions et de mouvements de lèvres apparemment aléatoires tout en fixant son propre reflet dans le miroir.

Ensuite, les scientifiques ont fait asseoir EMO devant des heures de vidéos YouTube montrant des humains parlant dans différentes langues et chantant. Cela lui a permis de relier sa connaissance de la façon dont ses moteurs produisaient des mouvements faciaux aux sons correspondants, le tout sans aucune compréhension de ce qui était dit. Finalement, EMO a été capable de prendre l’audio parlé dans 10 langues différentes et de synchroniser ses lèvres presque parfaitement.

« Nous avons eu des difficultés particulières avec les sons durs comme le « B » et avec les sons impliquant le plissement des lèvres, comme le « W » », a déclaré Hod Lipson, professeur d’ingénierie et directeur du Creative Machines Lab de Columbia, dans un communiqué. « Mais ces capacités s’amélioreront probablement avec le temps et la pratique. »

Plus d’un roboticien a essayé et échoué à créer un humanoïde convaincant, alors avant de dévoiler EMO au monde, il fallait le mettre à l’épreuve devant de vraies personnes. Les scientifiques ont ensuite montré des vidéos du robot parlant en utilisant le modèle VLA et deux autres approches pour contrôler sa bouche à 1 300 volontaires, ainsi qu’une vidéo de référence démontrant un mouvement idéal des lèvres.

Les deux autres approches étaient une base de référence d’amplitude, dans laquelle EMO bougeait ses lèvres en fonction du volume de l’audio, et une base de référence des points de repère du voisin le plus proche, dans laquelle il imitait les mouvements faciaux qu’il avait vu d’autres faire qui produisaient des sons similaires. Les volontaires ont été invités à choisir le clip qui correspondait le mieux au mouvement idéal des lèvres, et ils ont choisi VLA pour 62,46 % des cas, contre 23,15 % et 14,38 % pour les bases de référence de l’amplitude et des points de repère du voisin le plus proche, respectivement.

Les soignants robotisés auront besoin de visages amicaux

Bien qu’il existe des différences entre les sexes et les cultures dans la façon dont les gens répartissent leur regard, les humains en général se fient beaucoup aux indices faciaux lorsqu’ils interagissent les uns avec les autres. Une étude de suivi oculaire de 2021 a révélé que nous regardons le visage de nos partenaires de conversation 87 % du temps, dont environ 10 à 15 % du temps spécifiquement sur la bouche. D’autres recherches ont montré que les mouvements de la bouche sont si importants qu’ils affectent même ce que nous entendons.

Vous aimerez peut-être

-

Regardez : le nouveau robot humanoïde d’une entreprise chinoise bouge si doucement qu’ils ont dû l’ouvrir pour prouver qu’une personne ne s’y cachait pas

-

Pourquoi l’essor des robots humanoïdes pourrait rendre les interactions moins agréables

-

L’IA peut développer une « personnalité » spontanément avec un minimum d’invites, selon une étude. Qu’est-ce que cela signifie pour la façon dont nous l’utilisons ?

Les chercheurs pensent que le fait de négliger l’importance du visage est en partie la raison pour laquelle d’autres projets n’ont pas réussi à créer des robots convaincants.

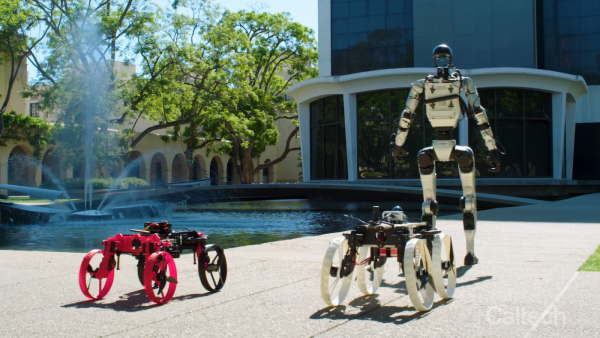

« Une grande partie de la robotique humanoïde d’aujourd’hui se concentre sur les mouvements des jambes et des mains, pour des activités comme la marche et la préhension », a déclaré M. Lipson. « Mais l’affection faciale est tout aussi importante pour toute application robotique impliquant l’interaction humaine. »

Alors que la technologie de l’IA continue de progresser à un rythme effréné, on s’attend à ce que les robots assument un nombre croissant de rôles qui nécessitent une interaction directe avec les humains, notamment dans les domaines de l’éducation, de la médecine et des soins aux personnes âgées. Cela signifie que leur efficacité sera corrélée à la mesure dans laquelle ils peuvent correspondre aux expressions faciales humaines.

ARTICLES CONNEXES

—La nouvelle IA du MIT peut apprendre elle-même à contrôler les robots en regardant le monde à travers leurs yeux — elle n’a besoin que d’une seule caméra

—Regardez ce robot humanoïde « ressusciter d’entre les morts » avec une vitesse et une stabilité effrayantes

—La Chine lance le premier robot au monde capable de fonctionner tout seul 24 h/24 et 7 j/7

« Les robots dotés de cette capacité auront clairement une bien meilleure capacité à communiquer avec les humains, car une partie importante de notre communication implique le langage corporel facial, et ce canal entier est encore inexploité », a déclaré l’auteur principal de l’étude, Yuhang Hu, dans le communiqué de presse.

Mais son équipe n’est pas la seule à travailler à rendre les robots humanoïdes plus réalistes. En octobre 2025, une entreprise chinoise a publié une vidéo d’une tête de robot étrangement réaliste, créée dans le cadre de ses efforts pour rendre les interactions entre les personnes et les robots plus naturelles. L’année précédente, une équipe japonaise a dévoilé une peau artificielle auto-cicatrisante qui pourrait rendre les visages de robots plus humains.

Fiona Jackson

Fiona Jackson est une rédactrice et éditrice indépendante qui couvre principalement la science et la technologie. Elle a travaillé comme reporter au service scientifique du MailOnline et a également couvert les nouvelles technologies d’entreprise pour TechRepublic, eWEEK et TechHQ.

Fiona a fait ses dents en écrivant des reportages sur des sujets d’intérêt humain pour des organes de presse mondiaux à l’agence de presse SWNS. Elle a une maîtrise en chimie, un diplôme du NCTJ et un cocker spaniel nommé Sully, avec qui elle vit à Bristol, au Royaume-Uni.

Afficher plus de commentaires

Vous devez confirmer votre nom d’affichage public avant de commenter.

Veuillez vous déconnecter puis vous reconnecter, vous serez alors invité à entrer votre nom d’affichage.

Se déconnecterEn savoir plus

Regardez : le nouveau robot humanoïde d’une entreprise chinoise bouge si doucement qu’ils ont dû l’ouvrir pour prouver qu’une personne ne s’y cachait pas

Pourquoi l’essor des robots humanoïdes pourrait rendre les interactions moins agréables

L’IA peut développer une « personnalité » spontanément avec un minimum d’invites, selon une étude. Qu’est-ce que cela signifie pour la façon dont nous l’utilisons ?

Le nouveau robot humanoïde « Transformer » peut lancer un drone transformable sur son dos — regardez-le en action

Désactiver la capacité de l’IA à mentir la rend plus susceptible de prétendre qu’elle est consciente, selon une étude étrange

L’IA est de plus en plus performante dans la génération de visages — mais vous pouvez vous entraîner à repérer les faux

Dernières nouvelles en matière de robotique